Blog

Datenqualität verbessern:

Praktische Anleitungen für bessere Ergebnisse

Für viele Unternehmen ist die Qualität ihrer Daten und das damit einhergehende Datenmanagement ein echtes Thema.

Auf der einen Seite wächst die Bedeutung von Daten als Grundlage für wichtige Unternehmensentscheidungen und auf der anderen Seite wachsen aber auch mit steigenden Datenmengen die Probleme bei der optimalen Verwaltung, Transformation und Bereitstellung dieser Daten. Hier ist Verbesserung notwendig.

Das liegt insbesondere an den Qualitätsproblemen, die viele Organisationen umtreiben. Inkonsistente oder fehlerhafte Daten, Duplikate und Unsicherheiten bezüglich der Data Governance führen nicht nur zu Entscheidungsrisiken und ineffektiven Prozessen, sondern kosten auch jede Menge Zeit, um die Datenqualität – häufig manuell – wieder und wieder zu verbessern.

Wonach bemisst sich die Datenqualität?

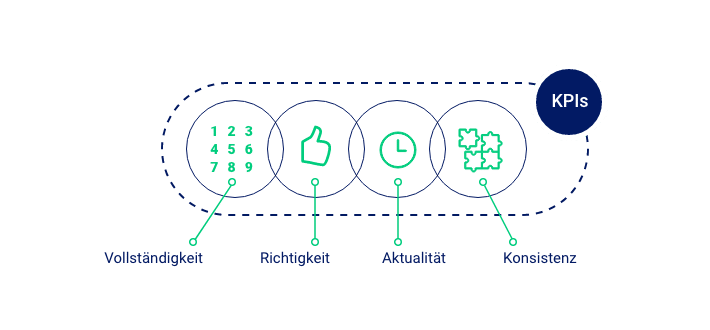

Die perfekte Datenqualität sieht für jeden Prozess, Datenempfänger und für jedes Ziel anders aus. Für das Management-Reporting braucht es andere Daten in einer weniger granularen Form als beispielsweise für das Publizieren in globale Datenpools, wo hohe Qualitätsstandards gefordert werden. Daher ist es zunächst einmal wichtig, für jeden Zweck die richtige Datenqualität zu definieren. Die wichtigsten KPIs hierfür sind:

Vollständigkeit

Ein häufiges Qualitätsproblem ist die Unvollständigkeit von Datensätzen – also das Fehlen von Attributwerten. Bei der Implementierung von Technologielösungen ist die Definition des Datenmodells eine wichtige Aufgabe, denn sie bestimmt von Anfang an, wie ein perfekter Datensatz aussehen muss, um jeden Datenempfänger und jeden Prozess optimal zu bedienen. Entsprechend muss bei der Datenpflege darauf geachtet werden, dass Datensätze vollständig angereichert und die Informationsanforderungen damit abgedeckt werden.

Richtigkeit

Ein offensichtliches Qualitätskriterium ist die Korrektheit der Angaben. Nur zu 100 Prozent zuverlässige und objektive Informationen sollten Eingang finden in die zentrale Datenhaltung des Unternehmens. Jede Ungenauigkeit und jeder Fehler verzerren die Realität, die von den Daten gespiegelt wird. Daher ist die Einhaltung dieses Qualitätskriteriums eine wichtige Voraussetzung für die Transformation von Unternehmen hin zu datengetriebenen Organisationen.

Aktualität

Eng verknüpft mit der Korrektheit der Daten ist auch ihre Aktualität. Kontinuierliche Data und Content Services sind notwendig, um zu gewährleisten, dass keine veralteten Daten genutzt werden. Gibt es Änderungen an einem Produkt oder werden bestimmte Sortimente nicht mehr angeboten, dann muss das unmittelbar in dem jeweils führenden System aktualisiert werden, damit diese Anpassungen entsprechend in den nachgelagerten Systemen und Prozessen berücksichtigt werden.

Konsistenz

Daten müssen nicht nur richtig und vollständig sein – ihre Gestaltungsvorgaben müssen zudem unbedingt eingehalten werden, um eine konsistente Datenhaltung zu gewährleisten und Daten überhaupt operabel zu machen. Bei der Definition des Datenmodells werden auch die Attribute und die entsprechenden Werteräume festgelegt. Innerhalb dieser Regeln müssen die Datensätze spezifiziert sein, damit die darauf aufbauenden Prozesse und Erkenntnisse akkurat und fehlerfrei sind.

Maßnahmen zur Verbesserung der Datenqualität

1. Die Rolle der Systemarchitektur

Wie bereits angedeutet, sind die jeweils führenden Systeme dafür verantwortlich, die richtige Datenqualität zu definieren und Daten aktuell, konsistent und korrekt vorzuhalten.

Das impliziert eine sehr klare Aufgaben- und Verantwortungsteilung in der Systemlandschaft – was zwar einleuchten mag, in vielen Unternehmen aber aktuell noch schwer umzusetzen ist. Besonders in komplexen Organisationsstrukturen ist es häufig so, dass jede Abteilung oder Landesorganisation eigene Systeme im Einsatz hat, manche Daten sogar lokal in irgendwelche Exceltabellen speichern und ein zentraler Zugriff auf wichtige Unternehmensdaten gar nicht möglich ist.

Daher ist der erste Schritt in Richtung qualitativ hochwertiger Daten die Definition und Umsetzung einer konsolidierten Systemlandschaft, auf deren Basis sämtliche Geschäftsprozesse abgebildet werden. Wichtig dabei ist die Berücksichtigung der kompletten digitalen Wertschöpfungskette und damit einhergehend der Kerndisziplinen PIM und DAM. Diese sind die Basistechnologien für sämtliche Product Content-Prozesse von der Erstellung und Aufbereitung bis hin zur Distribution von qualitativ hochwertigen Produktbotschaften.

2. Die Rolle der Datenprozesse

Während eine konsolidierte und klar definierte Systemlandschaft eine wichtige Voraussetzung für die Datenqualität ist, braucht es im Betrieb und bei der täglichen Arbeit mit Daten entsprechende Prozesse, Prüf- und Validierungsregeln, um die Datenqualitätsvorgaben durchzusetzen.

Automatisierungen sind hierfür der Schlüssel: Sie helfen den Mitarbeitern dabei, die Komplexität der Erstellung und Aussteuerung von Product Content zu kontrollieren und dabei zu jeder Zeit die geforderte Qualität zu liefern – in jedem Kanal. Entsprechende Regeln könnten beispielsweise darauf aufmerksam machen, wenn die Produktbilder nicht den geforderten Formaten im gewünschten Ausgabekanal entsprechen. Validierungsprozesse können die verantwortlichen Mitarbeiter auch darüber informieren, wenn bestimmte Datensätze nicht vollständig sind oder Dubletten gefunden wurden, die manuell aufgelöst werden müssen.

Auch bei der Erstellung von Datensätzen gibt es eine ganze Reihe an Prüfmechanismen, die den Beteiligten dabei helfen, die Qualität der angelegten Daten von Anfang an einzuhalten. Beispielsweise könnten die Systeme per Definition nur einen bestimmten Werteraum bei der Befüllung der Attribute zulassen und unzulässige Zahlenformate oder Beschreibungen verhindern, um die Datenkonsistenz zu sichern und eine spätere aufwendige Bereinigung zu vermeiden.

Damit solche Prozesse etabliert werden können, ist es wichtig, sich am Anfang Gedanken darüber zu machen, wie die systemübergreifenden Datenströme aussehen, wer daran beteiligt und wer für die Qualität der Daten verantwortlich sein soll. Darüber hinaus ist es empfehlenswert, nicht nur die aktuellen Ausgabekanäle und Organisationsstrukturen zu berücksichtigen, sondern auch für die Zukunft geplante Veränderungen in der Prozesslandschaft im Hinterkopf zu behalten.

3. Die Bedeutung von Data Governance

All das sind sehr komplexe Aufgaben. Hier kommt die sogenannte Data Governance zum Einsatz: Sie sorgt dafür, dass die definierten Regeln, Verantwortlichkeiten und Prüfprozesse durchgesetzt werden. Data Governance ist das wichtigste Werkzeug für Unternehmen, die ihre Datenqualität verbessern und damit langfristig ihre operative Effizienz sichern wollen.

Idealerweise werden die in der Data Governance festgelegten Bestimmungen in einem umfangreichen Dokument festgehalten und allen Beteiligten zentral zur Verfügung gestellt.

mediacockpit, eine Software, die PIM und DAM vereint, unterstützt Unternehmen dabei, die passende Datenqualität in jedem Touchpoint und für jeden Empfänger bereitzustellen. Unsere Lösung fokussiert sich auf die Verwaltung und Bereitstellung optimaler Produkt- und Mediendaten für die jeweiligen Anforderungen, die durch das generische Datenmodell perfekt abgebildet werden. Automatisierungen und intelligente Workflows sorgen dafür, dass die Qualitätsregeln kompromisslos eingehalten werden.

Fordern Sie Ihren umfassenden Data-Quality-Leitfaden an! Erfahren Sie, wie Sie effektive Data-Quality-Verfahren in Ihrem Unternehmen einführen. Unser Leitfaden umfasst bewährte Methoden, Regeln und Verantwortlichkeiten für die Gewährleistung qualitativ hochwertiger Daten in Ihren Systemen.

Highlighted Whitepaper

ePaper: Nachhaltiges Product Content Management mit PIM & DAM

So optimieren Sie Ihr Product Content Management nachhaltig: In unserem Whitepaper zeigen wir Ihnen, wie Sie mit einem PIM & DAM Ihre Prozesse optimieren – inklusive wertvollen Insights und praxiserprobten Strategien.

Zusammen mehr erreichen

Wir glauben an den Wert von Kollaboration und Austausch. Das gilt sowohl für unsere Kundenprojekte, aus denen wir viele wertvolle Erkenntnisse für unsere Produktentwicklung generieren, als auch für unser wachsendes Partnernetzwerk, mit dem wir unsere Kunden umfassend bei ihrer Digitalisierung unterstützen.